Comment être sûr d’obtenir un bon référencement Google ?

Découvrez un contenu riche en informations pour connaitre les tenants et les aboutissants du SEO.

Vous souhaitez connaitre le fonctionnement du référencement sur les moteurs de recherche ? Vous êtes au bon endroit.

Nous allons détailler ici, le guide le plus complet jamais rencontré sur le web concernant l’écosystème du référencement naturel. Tout ce que vous devez savoir sur le SEO se trouve dans les blocs suivants.

Qu’est-ce que le référencement naturel ?

Le référencement naturel est l’art d’appliquer une série d’optimisations afin de positionner ou améliorer le positionnement d’une page web sur un moteur de recherche. L’objectif étant de gagner en visibilité auprès des internautes.

Pour bien cerner ses enjeux nous allons prendre un exemple.

Admettons que vous vous trouviez sur une grande place de marché avec une allée centrale et plusieurs embranchements permettant d’accéder à des allées plus petites. Cette voie principale sera forcément plus peuplée que les rues parallèles (plus facile d’accès, plus grande et pouvant accueillir plus de monde). Les marchands présents à cet endroit auront donc plus de visibilité auprès des visiteurs et attireront de fait, beaucoup plus de clients.

Les emplacements sur cette allée sont très prisés, il y a ainsi beaucoup de concurrence pour obtenir une place à ces endroits.

Le gestionnaire de cette place de marché a tout intérêt à positionner les marchands ayant le plus de succès afin de satisfaire le plus de visiteurs possible.

Le principe du référencement web est le même !

Vous l’aurez compris, Google prend le rôle du gestionnaire de la place de marché, les marchands sont les sites web, l’allée principale est la première page des résultats du moteur de recherche et les visiteurs sont les internautes.

Son intérêt est donc de donner beaucoup plus de visibilité à votre entreprise sur ces plateformes. En atteignant les premières positions de la première page des résultats, votre site sera plus visible que les sites moins bien classés sur le mot-clé visé. Vous captez donc plus de trafic et optimisez vos chances de convertir vos visiteurs en clients.

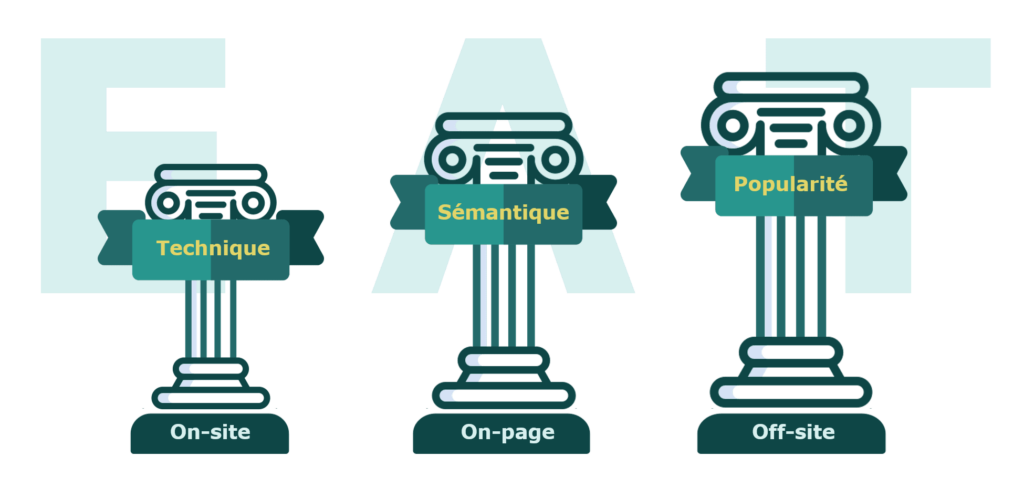

3. Les 3 piliers du référencement naturel

Vous souhaitez mettre en place une stratégie de référencement pour votre site ?

Nous allons vous faire découvrir ici tout ce que vous devez savoir pour commencer à travailler le SEO de votre site internet. C’est un métier qui peut s’apprendre rapidement si on est assez curieux et dégourdi. Cependant il faut aussi savoir que l’expérience joue beaucoup sur les performances d’un site. Vous pouvez donc réaliser votre référencement tout seul mais l’aide d’une agence SEO comme Tactee peut s’avérer très utile pour côtoyer les Tops positions.

Sachez tout d’abord que 3 principaux piliers le compose : l’aspect technique, sémantique puis netlinking (en général les actions à mener se déroulent toujours dans cet ordre). Chacune de ces parties doit répondre à des critères de positionnement imposés par les moteurs, que nous allons vous détailler ci-dessous.

A) L’aspect technique

L’optimisation technique permet de bâtir un socle solide pour votre site afin que les robots (appelés aussi bots, spiders ou crawlers) ne rencontrent aucun problème lorsqu’ils le crawlent (visitent). C’est le premier élément que l’on regarde lorsque l’on effectue un audit SEO complet. Une agence SEO réalisera alors un audit technique qui lui permettra d’explorer finement vos pages, de les indexer puis de les positionner.

1. Les critères de positionnement on-page

Certaines composantes ont des pondérations très faibles concernant leur importance dans le ranking. Il n’empêche qu’optimiser l’ensemble de ces éléments contribuera à la performance globale de votre site :

- L’amélioration du crawl (paramétrage du robots.txt, sitemap.xml, plan du site, organisation du maillage interne)

- L’indexation (gestion des canonicals, élimination du duplicate content)

- Le balisage sémantique (optimisation des balises Title, Méta-description, H1)

- La structure de vos documents (amélioration des balises Hn)

- L’architecture de votre site (définition des URL, gestion du maillage interne)

- La vitesse de chargement des ressources (amélioration des webperf)

- La gestion des images (allègement du poids des images, nommage des images, rédaction des attributs ALT)

- L’alimentation du Knowledge Graph (mise en place de données structurées)

- La version mobile (site responsive, gestion de l’UX, mobile first)

2. L’optimisation du crawl des robots

Google a besoin d’accéder à vos pages pour pouvoir les intégrer à son index puis les classer. Il est donc indispensable que l’ensemble des éléments importants et stratégiques soient accessibles.

Pour cela vous pouvez créer un fichier sitemap.xml qui va regrouper toutes les URL de votre site. Celles-ci doivent être valides et canoniques (pas d’URL en erreurs ou redirigées). Vous pouvez mettre en place un sitemap index afin de regrouper tous vos sitemaps. Vous pourrez ainsi classer vos URL en fonction de vos catégories (catégories, produits, articles de blog, images,etc.)

L’utilisation d’un plan du site (différent du sitemap) est une bonne pratique. Il s’agit d’un document HTML listant toutes les URL du site et généralement accessible dans le footer afin d’être facilement crawlable par GoogleBot.

Il faut savoir que le géant Américain attribue un nombre limité de ressources lorsqu’il visite votre site. C’est-à-dire qu’il ne va pas crawler l’ensemble de votre site mais seulement une partie. On appelle cela, le budget crawl. Un document HTML crawlé plusieurs fois par jour aura plus de chance d’être bien positionné qu’une page crawlée tous les mois. Il faut donc maîtriser ce quota de crawl afin de guider les bots vers les bonnes pages que l’on souhaite référencer. Pour cela, on peut bloquer certaines ressources ou slugs qui ne sont pas intéressantes pour les bots (ex : la page panier d’un e-commerce). Générer un fichier robots.txt sera utile pour effectuer ces directives. Le robots.txt est un fichier que l’on retrouve à la racine du site. C’est le premier fichier qu’un bot va visiter pour suivre les consignes de crawl. Il est alors recommandé d’y intégrer l’URL du sitemap pour que les bots y accèdent plus facilement.

Enfin, pour optimiser le crawl, il est important de ne pas avoir de liens cassés (en erreur 404 par exemple) qui pourraient nuire à l’ « image » de votre site côté crawlers. Cet examen vous révélera toutes ces anomalies sur chacune des URLs concernées.

3. L’indexation des pages

Une fois que les bots ont visité les pages d’un site, ils peuvent décider de les ajouter à leur index. Ce qu’on appelle l’indexation est le fait d’avoir ses URLs répertoriées dans Google (petite astuce pour savoir si l’une d’entre elles est indexée, tapez dans Google site:monurl.com, si un résultat apparaît c’est qu’elle est indexée).

Afin que ce dernier puisse indexer les bons documents, il faut rajouter des balises canonical sur toutes vos pages. Cela permettra de signifier qu’elles sont les documents originaux à indexer.

Il est également recommandé d’éliminer le contenu dupliqué (duplicate content). Les URLs très similaires (plus de 75% de taux de similarité) ne sont pas très bien vues par les machines. De plus, cela gaspille votre quota d’exploration (ils passent sur 2 contenus identiques) et vous pourriez vous retrouver avec la mauvaise URL indexée. Pour éviter ce problème, vous pouvez canonicaliser les éléments dupliqués vers la page originale ou les rediriger vers la bonne URL (Redirection 301).

4. La structure du site et de vos pages

En référencement, on entend par structure, l’organisation de différents éléments sur votre site, que ce soit la hiérarchisation de vos documents, leur construction sémantique et la classification de vos URLs.

Cette hiérarchisation peut se faire de manière logique ou thématique. La construction d’un bon maillage interne via le menu, le footer ou en plein texte permet de naviguer entre des documents sémantiquement proches. Cela donne plus de cohérence à la navigation.

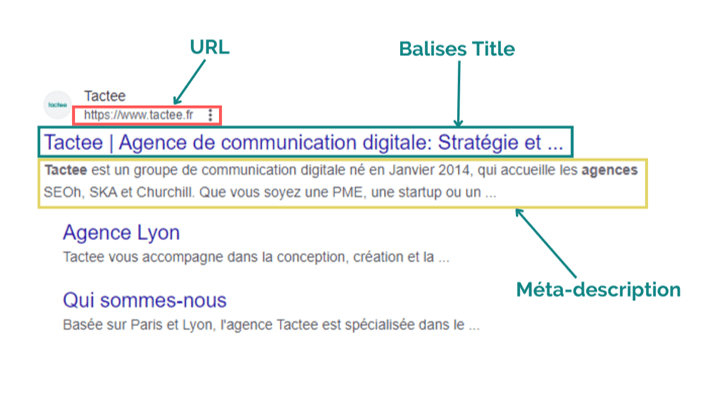

Le balisage sémantique est un élément important du positionnement. La balise Title est visiblement le critère le plus important en référencement SEO. Il est fondamental de travailler cet élément en y intégrant les mots-clés que vous visez.

La balise meta-description n’entre pas en compte dans les signaux de ranking, en revanche elle jouera un rôle intéressant sur votre taux de clic si elle est bien travaillée. Il faudra alors veiller à placer des expressions poussant à l’action (« Découvrez », « visitez », « contactez-nous » etc.) et décrire du mieux possible la page qui se trouve derrière.

Le balisage Hn quant à lui sert à structurer sémantiquement vos documents. On construit sa page comme si l’on rédigeait une dissertation (titre, sous-titres, sous-sous-titres etc.). En général, on dit que les bots doivent comprendre le sujet de celle-ci uniquement en lisant les balises Hn. Pensez donc à thématiser vos Hn.

Enfin la construction des URLs de votre site permet de comprendre comment est structuré votre site. C’est également utile lorsque l’on souhaite isoler un pattern pour analyser une catégorie d’URL. Même si le poids est très faible, il est toujours recommandé d’y intégrer les expressions ciblées.

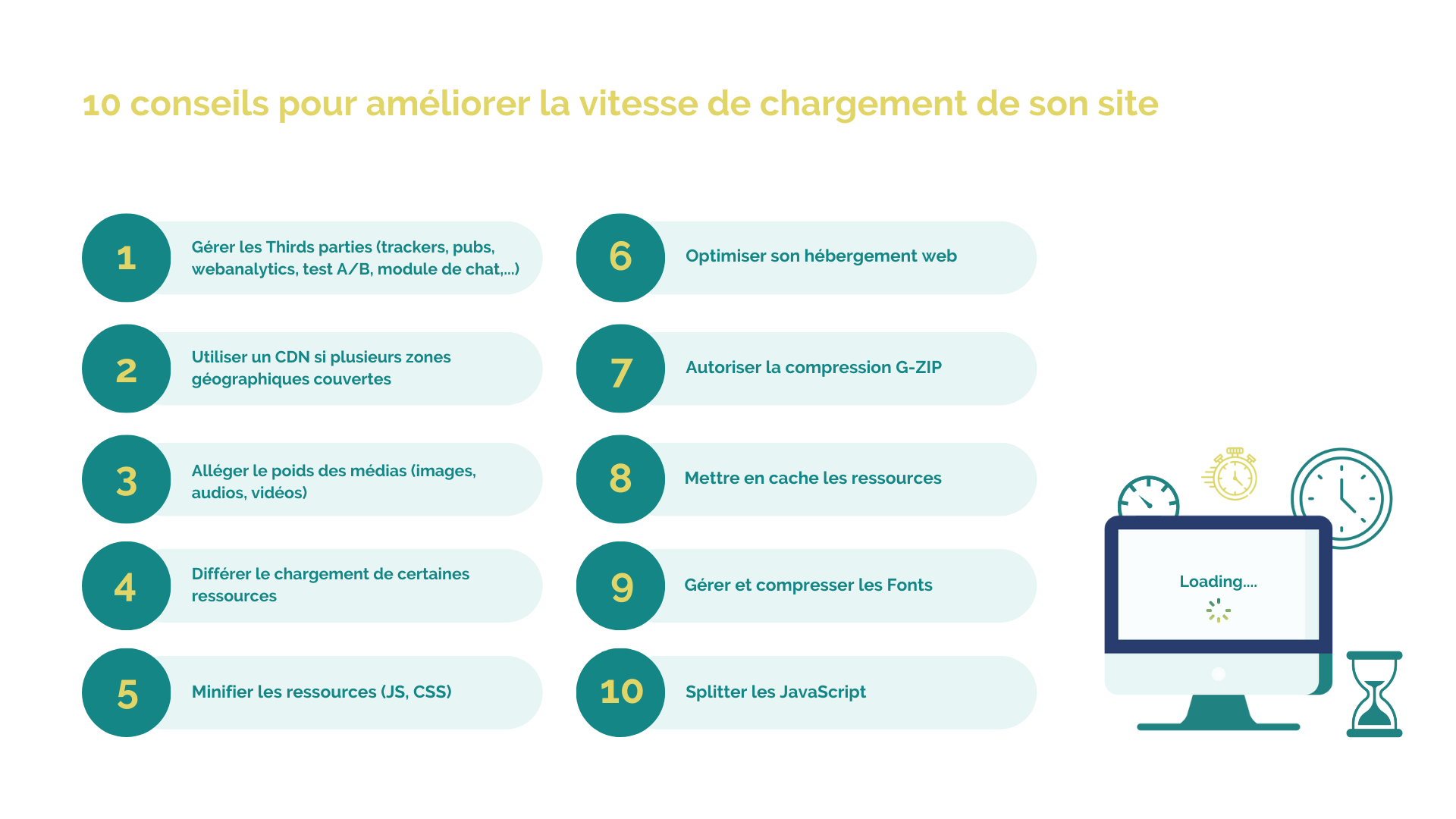

5. Les webperformances

La vitesse de chargement de vos pages est à la fois importante pour les utilisateurs (qui ont besoin d’instantanéité sur le web) et les robots (qui n’ont pas le temps de gaspiller des ressources). Travailler sa webperf s’avère alors intéressant pour votre référencement. Les améliorations de vitesse de chargement les plus fréquentes sont liées au poids des images, qu’il faut alléger le plus possible sans pour autant perdre en qualité. On fait appel également à de la mise en cache et de la minification de fichiers. Depuis juin 2021, Google a lancé, dans la cadre de la « Google Page Expérience », les Core Web Vitals, qui représentent une facette de l’expérience utilisateur. Ils sont mesurables en conditions réelles via des ressources mises à disposition comme Page Speed Insight. Trois aspects composent les Core Web Vitals :

- Le LCP (Largest Contentful Paint) : C’est le moment où l’élément le plus important en termes de taille (image, bloc de texte, etc) apparaît à l’écran (au niveau du viewport) ;

- Le FID (First Input Delay) : Il va mesurer la réactivité suite à une interaction sur une page ;

- Le CLS (Cumulative Layout Shift) : Cet indicateur mesure la stabilité visuelle. Il détecte les déplacements impromptus des éléments de la page à cause d’éléments dynamiques qui apparaissent au fur et à mesure, comme les pubs, vidéos, fonctionnalités etc.

B) La partie sémantique : le poids des mots

Une fois les facteurs bloquants précédents levés, il faut se concentrer sur l’audit sémantique de votre site. C’est-à-dire sur quelles expressions nous voulons ressortir et quel type de discours sera le plus adapté pour se positionner.

1. Les critères de positionnement on-page

Les critères de positionnement sémantique sont plus subtiles que ceux explicités précédemment. Ce sont les modèles complexes des algorithmes qui donneront un score sémantique au document. Vous serez donc plus ou moins positionnés en fonction :

- Du choix de vos mots-clés ;

- De la qualité de rédaction ;

- Des relations sémantiques entre les pages ;

2. Comment choisir ses mots-clés ?

Le choix des mots lors d’une étude sémantique dépend de beaucoup de variables.

- De votre marché : est-ce un marché concurrentiel ou alors de niche ;

- De votre budget alloué au référencement naturel SEO de votre site ;

- De l’intention de recherche des internautes ;

- De la typologie/popularité de votre site.

En fonction de ces éléments nous pouvons déjà nous orienter sur des choix de des expressions génériques, middle-traîne ou longue-traîne.

Pour faire simple :

Concurrence forte + Faible budget = Longue traîne

Concurrence forte + Gros budget = Mots-clés génériques

Concurrence faible + Faible budget = Middle traîne

Concurrence faible + Gros budget = Mots-clés génériques

3. L’intention de recherche en SEO

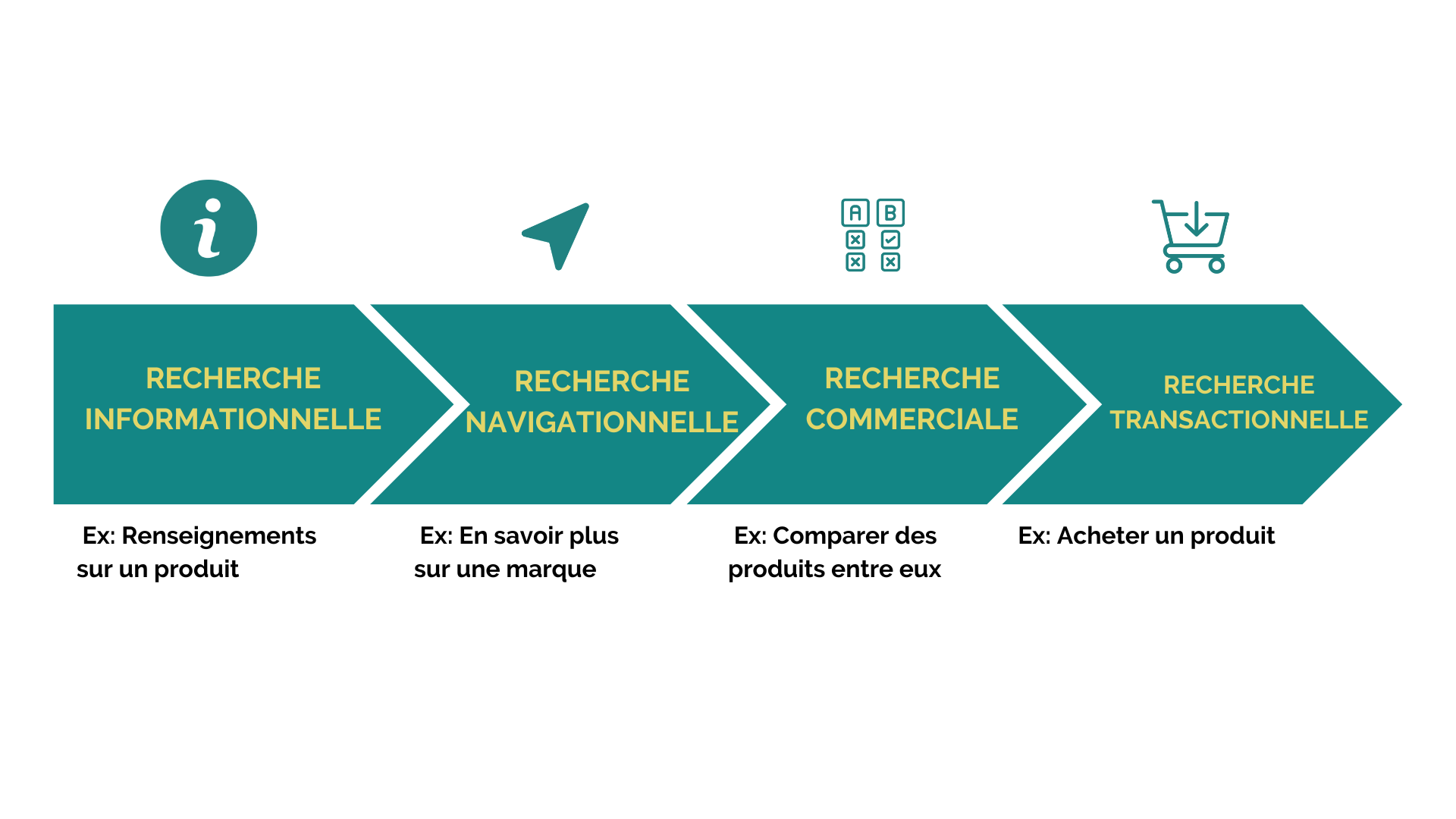

Analyser l’intention de recherche permet de connaître le type de document attendu par Google pour être positionné sur la bonne expression. On dénombre 4 intentions de recherche :

- La recherche informationnelle (on cherche des renseignements sur un produit par exemple)

- La recherche navigationnelle (on cherche à en savoir plus sur une marque)

- La recherche commerciale (on cherche à comparer des produits entre eux)

- La recherche transactionnelle (on cherche à acheter un produit)

Vous l’aurez compris, si nous sommes sur un besoin informationnel, nous n’allons pas créer une page produit qui aura plutôt vocation à répondre à un besoin transactionnel.

4. Les requêtes génériques

Ils sont très recherchés par les internautes. Les sites cherchent tous à ranker sur ces expressions susceptibles de leur rapporter énormément de trafic. Elles ont donc un fort volume de recherche et une forte concurrence. Vous ne devez les choisir que si vous avez déjà une forte notoriété sur la toile et de manière générale sur votre marché. Le budget sera un élément déterminant dans la sélection. En effet, n’espérez pas viser un Top 3 sur du générique avec un faible investissement.

5. La longue-traine

Cette notion très utilisée chez les SEO, fait allusion à une expression comportant plus de 3 mots, qui va capter peu de visiteurs car moins recherchée, mais qui seront beaucoup plus qualifiés. Ces expressions étant peu recherchées, elles sont ainsi moins concurrentielles. Un site avec une faible enveloppe et peu de notoriété aura plus de chance de se classer dans les Tops positions.

6. Le cocon sémantique

Le cocon sémantique (ou Topic Cluster) est un concept de structure qui permet de construire un groupe de pages autour d’une thématique liée à l’activité du site. Le but étant de créer des textes informationnelles sémantiquement proches les unes des autres qui viendront pousser une page transactionnelle. La contextualisation du maillage interne est très importante pour assurer un bon glissement sémantique.

Les étapes de la construction d’un cocon sémantique :

- Examen des personas, étude de leurs besoins et de la concurrence ;

- Détection d’expressions sémantiquement proches et pouvant être traitées en sujets bien précis ;

- Structure du cocon sémantique en entonnoir inversé (on cherchera à faire remonter les visiteurs vers la page cible afin qu’ils puissent convertir) ;

- Réalisation de la stratégie éditoriale avec le détail de chaque texte (champs sémantiques, titre, structure, nombre de mots, nombre de paragraphes, Title, Meta-description, ancres de lien)

- Réalisation du maillage interne entre les pages mères, filles et sœurs

- Rédaction et intégration des textes

- Obfuscation éventuelle de certains liens structurels

7. Qu’est-ce qu’un contenu de qualité ?

La firme de Mountain View le dit souvent, « Content is king ». Chaque webmaster doit alors générer d’excellents contenus pour ses visiteurs. Mais alors, qu’est-ce qu’un contenu de qualité ?

C’est un document (texte, image, vidéo, infographie, podcast…) qui va répondre à un besoin (d’information, d’achat, d’interaction, de notoriété etc.). Le contenu doit délivrer la meilleure info possible et pas de blabla inutile.

Petite parenthèse: De nos jours, il est très simple de rédiger du contenu de qualité si l’on si prend bien. Notamment grâce à l’arrivée de l’IA dans la rédaction web et ChatGPT/GPT4. Depuis Novembre 2022, ce chatbot est un bouleversement dans le monde du digital tant il menace de nombreux métiers même si le fonctionnement et l’utilisation de ChatGPT vous fera gagner énormément de temps. L’outil est très simple à prendre en main mais il faut produire des prompts de qualité pour obtenir de bons contenus à intégrer sur votre site.

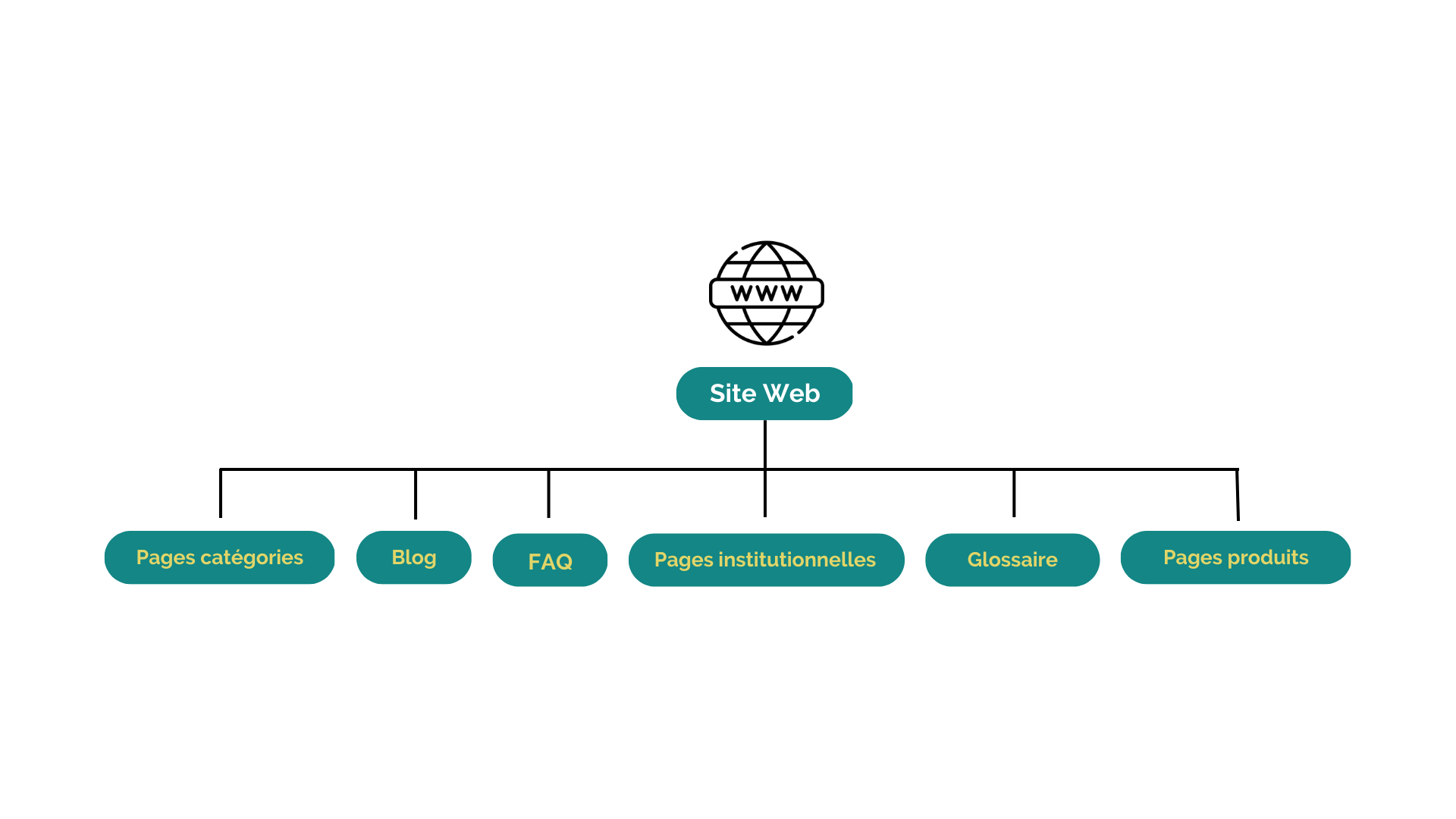

Il existe des types de pages spécifiques à chaque besoin des visiteurs.

Nous vous listons ici une liste (non-exhaustive) des principaux contenus que l’on peut trouver sur un site web :

- Pages catégories

Elles sont souvent synonymes de pages stratégiques car elles sont généralement plus facilement accessibles pour les robots et les utilisateurs. On y associe généralement des requêtes à forte volumétrie de recherche. Elles présentent l’ensemble de vos principales activités et doivent contenir des paragraphes suffisamment optimisés pour se positionner sur l’expression visée.

- Pages produits

La rédaction des pages produits doit être aussi précise que possible. Le but étant de se démarquer de la concurrence qui peut vendre les mêmes biens ou services que vous. La plupart d’entre elles peuvent donc se retrouver facilement dupliquées. C’est pourquoi, en ajoutant le plus d’éléments possibles (photos, descriptifs, stocks, livraisons, conditions de retours, promotions, avis etc) vous rassurez vos visiteurs.

Les éléments des pages produits peuvent être encapsulés avec de la donnée structurée (idéalement J-SON LD) afin qu’ils puissent ressortir dans les SERP et ainsi attirer plus facilement l’œil des internautes.

- Blog

Nous entendons ici, un espace sur votre site où l’on peut alimenter régulièrement votre site en contenus utiles, intéressants pour vos visiteurs. Ce peut être des contenus chauds liés à une saisonnalité (marronniers), des sujets d’actualité, des conseils, des études, des contenus de fond, des contenus informationnels/descriptifs ou ayant pour vocation de créer de l’interaction etc.

C’est une excellente façon de prouver son expertise. Grâce à un maillage interne optimal il permet même de transmettre de la popularité aux pages stratégiques.

- Glossaire

Sur certains sites, insérer un glossaire peut s’avérer une bonne stratégie. Cela permet d’agrémenter la sémantique globale du site car nous abordons l’ensemble des thèmes, vocabulaires, jargons de votre secteur.

- FAQ

Les FAQ peuvent faire partie intégrante d’une page de votre site ou alors être implémentées sur une page dédiée. Cet élément peut également ressortir dans les résultats grâce aux données structurées. La foire aux questions améliore l’UX de votre site en donnant des renseignements précis sur vos produits ou services.

- Pages institutionnelles

Même si elles n’ont pas vocation à se positionner, ces rubriques sont très importantes pour l’aspect EAT de votre marque. Ce sont des éléments de réassurance qui humanisent un peu plus votre site et votre entreprise.

C) La popularité : élément capital du référencement Google

A la fin des années 90, Google est sorti du lot grâce à un algorithme lié à la popularité d’un site : le Pagerank (en référence à Larry Page, créateur de ce concept). La popularité d’un site se manifeste par les liens et/ou les mentions qu’il reçoit.

1. Les critères de positionnement off-page

Il en existe différents à prendre en compte, que vous pourrez retrouver ici.

En général, on compte 3 principaux éléments dans une bonne stratégie SEO off-site :

- Les backlink qui pointent vers votre site

- Toutes les mentions de votre marque que l’on peut retrouver sur la toile

- Les « signaux sociaux » venant principalement des réseaux sociaux et plus globalement du « bruit » qui est fait autour de votre marque.

2. Comment choisir un bon lien pour son référencement web

Choisir un bon lien n’est pas si simple puisqu’il faut arriver à combiner de nombreux signaux afin de sélectionner les meilleurs supports. L’expertise d’une agence de netlinking peut s’avérer d’une grande aide dans ce cas-là car il faut pouvoir manier la popularité d’un site avec précaution sous peine d’être pénalisé. Majestic, Ahref ou Semrush (qui seront détaillés plus bas) vous aideront dans l’élaboration de vos campagnes de backlink).

3. Les données à prendre en compte pour choisir un lien

-

- Trust Flow : Prend en compte la qualité des liens entrants et montre donc la confiance que l’on pourrait accorder à un site – Indicateur Majestic.

- Citation Flow : Prend en compte la quantité de backlink entrants que reçoit le support. Il indique la popularité d’un site – Indicateur Majestic.

- Domain Authority : Indicateur de Moz qui évalue la popularité d’un site (comme le TF).

- Nombre de domaines référents : Ou le nombre de sites qui pointent vers le média. Plus le nombre est important, mieux c’est.

- Nombre de backlink : L’idée est d’essayer de tendre vers 1 domaine référent = 1 backlink.

- Topical Trust Flow/thématique : La thématique dominante des principaux sites qui vous font des backlink. Nous cherchons en général à trouver des supports ayant les mêmes thématiques que celle du site que l’on vise.

- Trafic du site : le nombre de visiteurs est un indicateur de popularité d’un média. Plus il sera visité plus cela signifie qu’il est « populaire ».

- Des positions acquises par le site : Cette donnée nous montre si le support se positionne sur les thématiques que l’on vise.

- Antériorité du site : Plus le site est ancien mieux c’est.

- Nombre de pages indexées

Les principales plateformes de netlinking

La plupart des agences digitales qui réalisent des opérations de linking passent par des plateformes pour accélérer la récolte de backlink et choisir les meilleurs supports pour leurs clients. Chaque plateforme possède son propre mode de fonctionnement (liens choisis par la plateforme elle-même ou par vous, qualité des supports, backlinks sur pages existantes, etc). Vous trouverez ici les 13 meilleures plateformes de linking.

| Plateformes | Nom | Descriptifs | Les plus | Tarifs | Catalogue |

|---|---|---|---|---|---|

|

Accesslink | AccessLink est une plateforme parfaite pour commencer à obtenir ses premiers backlink. L’interface est intuitive et permet de créer vos campagnes rapidement. |

|

À partir de 10€ | + de 4 000 éditeurs |

|

Boosterlink | Boosterlink permet d’échanger ou d’acheter des liens depuis leur large catalogue. |

|

À partir de 14€ | + de 25 000 éditeurs |

|

Dealer de Temps | Dealer de Temps dénote des autres acteurs du marché, car il ne s’agit pas ici d’achat mais d’échange de liens. Vous publiez des articles rédigés par des webmasters sur votre site puis vous gagnez des crédits que vous pourrez réinvestir pour recevoir des backlinks. |

|

Gratuit (si vous vous débrouillez bien) | + de 6 000 éditeurs |

|

Develink | Develink propose de nombreux supports. Nous ne connaissons pas les prix appliqués mais la plateforme offre un bon suivi de campagne et de bons conseils. |

|

N-C | + de 20 000 éditeurs |

|

eReferer | Ereferer dispose d’un des plus large catalogue de médias. Le prix des backlink est vraiment imbattable. |

|

À partir de 2€ | + de 45 000 éditeurs |

|

Getfluence | GetFluence est une plateforme haut de gamme. Si vous avez besoin de lien d’autorité cela se passe par ici. |

|

À partir de 130€ | + de 10 000 éditeurs |

|

Linksgarden | Editée par G2 Edition et fondée par Jacky Giang, Linksgarden propose des backlink peu cher mais les supports sont qualitatifs. |

|

À partir de 13€ | + de 3 500 éditeurs |

|

Netlinking.fr | Netlinking.fr est une plateforme fondée par Mickaël Priol. Elle vous offre la possibilité d’automatiser vos campagnes ou de choisir vous-même vos supports. |

|

À partir de 37.5€ | + de 10 000 éditeurs |

|

NextLevel | Fondée par Julien Jimenez, c’est la plateforme qui propose des supports se positionnant sur les mots qui vous intéresse. La transmission du jus de liens se retrouve donc encore plus cohérente. |

|

À partir de 50€ | + de 10 000 éditeurs |

|

PaperClub | Paperclub offre des supports intéressants lorsque vous voulez améliorer votre stratégie de notoriété de marque. Les prix varient beaucoup en fonction de votre stratégie de backlink. |

|

N-C | + de 28 000 éditeurs |

|

RocketLinks | RocketLinks est l'une des premières plateformes à proposer de choisir soi-même les supports sur lesquels vous souhaitez faire du linking. Vous pourrez choisir vos médias en fonction de nombreuses données. |

|

À partir de 15€ | + de 80 000 éditeurs |

|

SemJuice | Une plateforme ultra-vitaminée qui entre parfaitement dans la thématique du jus. Les nombreuses thématiques de SemJuice vous permettront même de vous positionner sur des marchés de niches. Les nombreuses thématiques de Semjuice vous permettront même de vous positionner sur des marchés de niches. |

|

À partir de 22.5€ | + de 10 000 éditeurs |

|

Soumettre | Plateforme fondée par Rodrigue Fenard, Soumettre est très facile à prendre en main et offre un grand choix de services (Linking, relation de presse, rédaction). |

|

À partir de 10€ | + de 32 000 éditeurs |

A) L’algorithme : son fonctionnement et son évolution

Historiquement, le concept de gestion de l’information et donc de moteur de recherche remonte bien avant les années 90. À la fin des années 40/début des années 50, les entreprises commencent à avoir énormément de données à traiter. Des universitaires et scientifiques vont commencer à travailler sur des projets afin de traiter les besoins informationnels. Nous ne nous épancherons pas sur les notions qui suivront dans ce paragraphe car complexes et longues à aborder. Si vous souhaitez en savoir plus et rentrer vraiment dans le détail, nous ne pouvons que vous conseiller la formation des Frères Peyronnet.

Listing des principaux acteurs ayant travaillé sur la recherche d’information avant les années 90 :

-

Robert Taylor : Il va mettre en place un formalisme au niveau du besoin informationnel.

-

Gerard Salton: Inventeur du fameux modèle vectoriel et du Cosinus de Salton. Il mesure la pertinence d’un document, d’une page web en fonction de l’information demandée. Ses travaux sont encore utilisés par la plupart des moteurs.

-

Karen Sparck-Jones : Créatrice du TF-IDF (Term Frequency – Inverse Document Frequency). C’est un score donné à un document en fonction des termes utilisés.

-

Stephen Roberston : inventeur du BM25, une méthode de pondération d’un document.

Puis vint le temps du World Wide Web, créé par Tim Berners-Lee en 1991. C’est à ce moment-là que de nouveaux chercheurs se sont mis à appliquer les trouvailles de leurs prédécesseurs au monde d’internet. Les premiers moteurs de recherche apparaissent. Et bien entendu, il y en a un qui va tirer son épingle du jeu : Je vous laisse deviner !

C’est notamment grâce à Larry Page et son PageRank que Google va devenir le géant qu’il est aujourd’hui. Là où toutes les machines cherchent à comprendre la sémantique d’un document en ligne, leur pertinence et l’intention des internautes, le géant Américain (actuellement dirigé par Sundar Pichai) va ajouter une nouvelle dimension à ses classements : la popularité.

Le PageRank aléatoire (premier du nom) est un algorithme de popularité. Il va modéliser à travers les liens hypertext le comportement de l’internaute lorsqu’il parcourt le web. L’idée c’est que quelque chose de populaire attire du monde. Il faut imaginer intuitivement que sur le web une page populaire est une page où il y a beaucoup de monde dessus.

Donc plus un site bénéficie de popularité, mieux il est classé.

Voici la formule Pagerank :

PR(u)=(1 – c)/N + c. ∑ PR(v)/ #liens(v)

u = une page de l’index

N = le nombre de pages qui sont dans l’index du moteur

c = c’est une constante mathématique qui vaut 0.85 (85%)

En plus des 2 créateurs de la firme de Mountain View, de nombreuses personnes ont contribué à l’évolution du search après les années 90 :

Voici une liste (non-exhaustive) des principaux acteurs ayant beaucoup apporté :

-

Hector Garcia Molina : il est l’un des plus grands chercheurs en termes de gestion de base de données. Il a créé de nombreux algos et a encadré des étudiants comme Sergueï Brin et Larry Page ;

-

Taher Haveliwala : inventeur du PageRank thématique que nous verrons plus loin ;

-

Zoltan Gyongyi : il a imaginé puis crée un algorithme de lutte anti-spam : le Trustrank ;

-

Jeff Dean : ingénieur de développement chez Google, il est à l’origine du filtre Panda ;

-

Tomas Mikolov : créateur de Word2vec, il a trouvé une méthode pour que chaque terme possède son propre vecteur de contexte. C’est-à-dire qu’il détermine la relation des mots (chaque phrase, chaque texte est examiné) ;

-

Jacob Devlin : il a été à l’origine de BERT.

Il existe d’autres versions améliorées du PageRank qui lui ont permis d’améliorer ses classements.

Vous trouverez ci-dessous les principaux algorithmes de classement de Google :

-

Le PageRank raisonnable : c’est un modèle plus évolué du surfeur aléatoire. Pour lui tous les liens ne se valent pas. Ils vont donc avoir un poids différent selon leur emplacement sur la page.

-

Le Learning-to-rank : c’est un algo de machine learning qui fabrique les SERPs. Il va apprendre pour chaque requête, quels sont les signaux importants et les pondérer en conséquence. Il arbitre ainsi les résultats.

-

Le Pagerank Thématique : Pensé par Taher Haveliwala, il va créer un PR associé à la thématique des pages. Il ajoute de l’information sémantique au PR.

-

Le Transition Rank : il va repérer les spammeurs en les piégeant. Il va volontairement faire perdre ou gagner des positions et attendre si des modifications sont apportées ensuite. Si c’est le cas, alors il considérera que les webmasters tentent de manipuler l’algo et les pénalisera.

B) La part de marché des moteurs de recherche

Part de marché dans le monde (source: StartCounter, 2019)

| Monde | Europe | Amér. Nord | Amér. Latine | Afrique | Océanie | Moyen Orient | France | USA | Russie | Chine | Corée Sud | Allemagne | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 94% | 94% | 87% | 97% | 96% | 95% | 97% | 92% | 85% | 52% | 2% | 76% | 94% | |

| Bing | 3.1% | 2.3% | 5.2% | 1.5% | 1.9% | 3.3% | 1.1% | 3.7% | 5.6% | 0.4% | - | 1.5% | 3% |

| Yahoo | 1.3% | - | 6.9% | 1% | 1.3% | 0.5% | 1% | 1.4% | 8.4% | - | - | 1.7% | 0.6% |

| DuckDuckGo | 0.6% | 0.4% | 0.9% | 0.1% | 0.1% | 0.4% | - | 0.4% | 1% | - | - | - | 0.6% |

| Baidu | 0.6% | - | - | - | - | - | - | - | - | - | 69% | - | - |

| Yandex | 0.7% | 1.7% | - | - | - | - | 0.9% | - | - | 45% | - | - | - |

| Naver | - | - | - | - | - | - | - | - | - | - | - | 18% | - |

| Mail.ru | - | - | - | - | - | - | - | - | - | 2.1% | - | - | - |

| Shenma | - | - | - | - | - | - | - | - | - | - | 4.5%- | - | - |

| Haosou | - | - | - | - | - | - | - | - | - | - | 2.4% | - | - |

C) Quelle est la liste des meilleurs moteurs de recherche dans le monde ?

| Moteur de recherche | Origine | Descriptif |

|---|---|---|

|

Etats-Unis | Créé par Larry Page et Sergueï Brin. C’est le numéro 1 mondial des moteurs de recherche. Le Pagerank mesurant la popularité d’un site leur a permis de se démarquer de la concurrence à la fin des années 90. |

|

Etats-Unis | Le moteur de recherche de Microsoft. Comme la plupart des autres plateformes, celui-ci est loin de Google en termes de part de marché mais progresse petit à petit. On note cependant de meilleurs taux de conversions sur Bing. |

|

Etats-Unis | Société américaine de services web, créée par Jerry Yang et David Filo, Yahoo est également un moteur de recherche. Ses résultats sont générés par Google et Bing. |

|

Chine | Baidu est LE moteur de recherche chinois. Idéal si vous souhaitez implanter votre business dans ce pays. Il détient le monopole en Chine avec 95% de parts de marché. |

|

Russie | Développé par les Russes, Yandex représente un peu plus de 44% de part de marché dans le pays. Ce n’est en revanche pas le n°1 du pays, Google est bel et bien le premier en Russie. |

|

France | Celui-là est français et met un point d’honneur à respecter la vie privée de ses utilisateurs (pas de tracking des recherches, de ciblage publicitaire et de données personnelles). Il connaît quelques difficultés à se développer. |

|

Etats-Unis | Celui-ci est également américain. Il offre la possibilité aux internautes d’avoir un contrôle sur leurs données personnelles. |

|

Allemagne | Ecosia se définit comme un moteur écologique en reversant des bénéfices aux associations œuvrant pour la reforestation de la planète. Ses résultats sont propulsés par Bing. |

|

République-Tchèque | Seznam est assez populaire dans son pays au point de concurrencer le géant Américain. Il s’est beaucoup développé dans les années 2000. |

|

Corée du Sud | Également appelé « le Google Sud-Coréen » Naver a été développé en 1999. Il génère une grosse partie des recherches réalisées dans le pays. |

5. Quels sont les principaux algorithmes de Google ?

| Algorithme | Nom | Descritpif |

|---|---|---|

|

Google Caffeine | Cette mise à jour est arrivée en 2009 et concerne principalement la rapidité d’indexation dans la SERP, l’amélioration du matching “mot-clé résultats de recherche” et l’amélioration de la vitesse de chargement des résultats. |

|

Google Panda | Panda est un filtre qui pénalise les sites ayant un contenu de mauvaise qualité ou dupliqué. La notion de mauvaise qualité fait référence à un texte trop court, peu enrichi sémantiquement ou abusant de keyword stuffing. Ce filtre fait partie du cœur de l’algorithme et est actif depuis 2011. Il est à ce jour avec Pingouin l’une des plus grosses mises à jour. |

|

Google Pingouin | Pingouin est un filtre apparu en avril 2012. Pingouin a pour mission de sanctionner les sites usant de pratiques “abusives” d’un point de vue backlinks. Cela pourrait notamment concerner les fermes de liens (méthode de linking artificielle visant à créer un ensemble de sites ayant des connexions entre eux), très présentes à cette époque.. |

|

Google Colibri | Colibri, appelé aussi “Hummingbird”, est une optimisation apparue en 2013. Il vient s’ajouter à Caffeine qui à son époque avait grandement amélioré la pertinence des résultats. Colibri a pour mission d’accentuer cette qualité sur des questions posées et des requêtes de plusieurs mots. |

|

Google Pigeon | Pigeon est une mise à jour importante car il est le premier à intervenir sur la recherche locale. Apparu en 2014 aux USA, il permet de proposer des résultats ciblés sur des requêtes locales. Cette mise à jour a permis l’apparition des Google Maps dans la SERP. |

|

Google Rank Brain | Rankbrain, sorti en 2015 par Greg Corrado, chercheur en neurosciences biologiques et IA. Celui-ci s’inscrit dans la suite de Colibri. Il intègre l’intelligence artificielle afin de proposer des résultats encore meilleurs. De plus, Rank Brain intègre le machine learning dans son algorithme ce qui lui permet d’apprendre du parcours des internautes. |

|

Google Mobile First | Le Mobile First est un système d’indexation basé prioritairement sur la version smartphone d’un site. Il est apparu en 2016 et a été déployé jusqu’en 2018. La dissociation de l’index sur téléphone et ordinateur a permis de proposer des renseignements plus adaptés aux internautes. |

|

Google Medic | Medic Update a eu un fort impact sur les sites traitant principalement de la santé et des e-commerces. Son nom a été attribué par Barry Schwartz. Cet algorithme se base sur le principe “Your Money Your Life” et l’EAT. |

|

Google Bert | BERT (Bidirectional Encoder Representations from Transformers) est un algorithme de traitement du langage basé sur les réseaux neuronaux. Cette méthode est couplée avec du machine learning qui permet de mieux comprendre les requêtes longues traînes et les relations entre chaque mot. |

|

Google Core Update | Un “Google Core Update” signifie littéralement une mise à jour majeure de Google. Ces Core Update sont généralement déployés entre 3 et 4 fois par an. |

Définition du SEO géolocalisé

Le référencement local consiste à travailler des pages, des fiches établissements ou du linking spécifique. Le but étant que ces pages soient visibles sur des termes intégrants une localité (ex : « agence SEO Lyon ») ou qui induisent une notion de lieux (ex : « magasin de bricolage »).

Pourquoi le référencement local est-il si important ?

(source : Google Study)

(source : Google)

(source : SearchEngineLand)

Quand on fait du référencement local, il existe de nombreuses façons de se rendre visible (Maps, My business, liens bleus, Featured Snippets…).

Nous cherchons à faire en sorte que les internautes se rendent directement dans les magasins/entreprises, qu’ils les appellent ou accèdent au site de votre établissement.

Pour cela, vous avez besoin de créer des pages locales (ou Store Locator) afin d’y retrouver toutes les infos nécessaires (n° de téléphone, adresse du lieu, mail, horaires d’ouverture, avis, FAQ sur la boutique, éventuellement vos tarifs, une maps si vous disposez de nombreux points de vente,…)

Ce sont des éléments de réassurance pour vos visiteurs. Couplés à de la donnée structurée, ces éléments pourront alimenter le Knowledge Graph du moteur concernant votre établissement et améliorer vos chances de ranker sur les expressions géolocales.

Pour savoir ce que propose une agence en référencement local, consultez cette page.

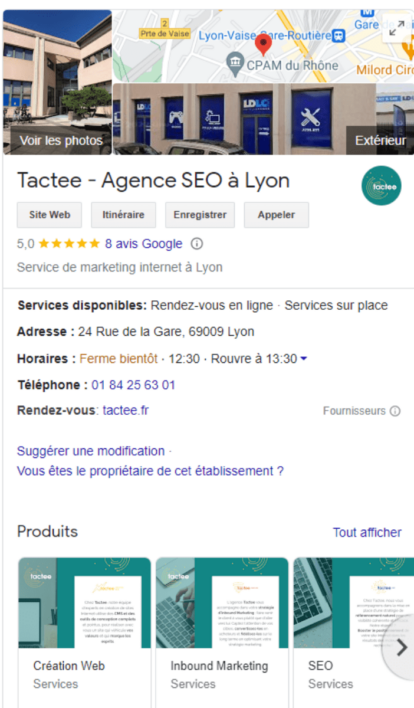

Les Google My business

Une fiche My Business (ou Google business profile) est un bloc d’information que l’on retrouve généralement à droite d’une SERP ou/et sur la Maps. La mise en place d’une My Business est gratuite. Vous pouvez consultez le support pour connaître les étapes de création de votre fiche. A l’instar des éléments d’un Store Locator (adresse, téléphone, horaires, avis, contact) vous pourrez rajouter une description, le lien de votre boutique en ligne, des évènements, des photos et répondre aux avis (pensez à enrichir la sémantique de vos commentaires).

Dans une stratégie géolocale, la typologie de backlink est importante. Un restaurant à Paris recevant des mentions de sites culinaires parisiens aura beaucoup plus de chance de ranker que s’il en recevait depuis des supports toulousains (moins pertinent).

La recherche de médias dont la thématique est la ville de votre business est une bonne pratique dans une campagne de linking géolocal.

Tout comme l’inscription dans des annuaires, même si cette pratique performe un peu moins de nos jours.

Les données structurées de type LocalBusiness en J-SON LD permettent aux crawlers de mieux cibler les informations importantes de vos locaux afin de diffuser les bons renseignements dans leur Knowledge Graph et leurs résultats. Il est conseillé de mettre le plus de précisions possible.

Définition du référencement international

C’est un aspect du référencement naturel qui doit faire partie intégrante de votre stratégie digitale globale. Il vous permet de travailler votre canal d’acquisition dans plusieurs pays/régions du monde. Vous devrez adapter votre stratégie dans chaque pays.

Il existe de nombreuses façons de faire du SEO international. Les problématiques clients sont toutes différentes et il est assez compliqué de gérer les différentes langues d’un site si l’on n’est pas avisé des techniques de référencement de site multilingue.

Vous devez vous poser les bonnes questions afin de maximiser vos conversions à l’international. Structurez-vous votre site en répertoire par pays, en sous-domaine par pays ou bien créez-vous un nom de domaine différent par localité ? C’est généralement la question la plus importante à se poser. Toute la stratégie découlera ensuite de ce choix.

De plus, il ne suffit pas de traduire simplement vos textes dans la langue locale. Les expressions travaillées ne sont pas les mêmes d’un pays à l’autre, les devises sont différentes, les intentions de recherches également. Les besoins de vos visiteurs seront différents en fonction des régions du monde, vous devrez donc avoir une stratégie bien définie par localité.

Il faut faire relativement attention aux textes dupliqués si l’on se trouve sur des pays différents qui parlent la même langue (exemple Espagne et Mexique). Cette gestion des langues et des pays est permise par la balise hreflang. Pour en savoir plus sur cette balise, vous pouvez lire notre article à ce sujet.

A) Quels sont les principaux KPI à suivre pour évaluer les performances SEO

Suivre les performances de ses actions est devenu un élément important dans une relation agence/client. Ces derniers souhaitent connaître les retombées des chantiers réalisés et notamment leur retour sur investissement (ROI). En général, les experts vont suivre :

-

Les positions de vos keywords ;

-

Le trafic sur votre site ;

-

Les conversions (les objectifs que vous vous êtes fixés) ;

-

Les pénalités (qui permettront de rectifier le tir si une mise à jour a eu lieu) ;

-

La metrics de popularité (Trust Flow, Citation Flow).

D’autres mesures plus précises peuvent être analysées mais elles sont plutôt liées à des données comportementales et pas forcément à vos actions directement (ex : durées des sessions, taux de rebonds, parcours d’achat…)

B) Solutions de suivi

Afin d’analyser toutes ces données, de nombreuses solutions sont disponibles pour suivre ces KPI.

Google Analytics (GA4) / Matomo / AT Internet

Ce sont des solutions gratuites ou payantes pour certaines. De nombreuses données sont traitées et vous pourrez mettre en place des tableaux de bords détaillés pour vos partenaires.

Sachez que certaines solutions ne sont pas RGPD compliant et que vous pourrez être sanctionnés par la CNIL si vous les installez.

Search Console

La Search Console (anciennement Webmastertools) fait partie des instruments mis à disposition par Google pour analyser uniquement des données organiques. Vous pourrez suivre le nombre de clics, d’impressions, de CTR et de positions moyennes pour chaque requête ou URL.

Vous aurez accès à l’indexation de vos pages, l’explorabilité de votre site, d’éventuelles erreurs rencontrées par le bots et toutes les données concernant la « Page Experience » ( Core Web Vitals, Ergonomie mobile, HTTPS).

Des rapports vous donnent accès aux backlinks détectés ou à des améliorations diverses comme les données structurées.

Enfin, vous pourrez savoir si une action manuelle a été appliquée sur votre site (pénalité humaine).

Google Tag Manager (GTM)

Google Tag Manager est un gestionnaire de balises. C’est-à-dire que vous pouvez traquer facilement ce que vous voulez sur votre site (des conversions, des mises au panier, des téléchargements, des abonnements etc.). Cette solution peut se plugger à des outils de suivi d’audience.

Le principe est simple : vous créez ou sélectionnez des variables qui seront attribuées à un déclencheur. Une fois ce déclencheur créé, il faudra lui associer une balise afin que celle-ci puisse remonter dans vos données.

9. Les outils à connaître pour faire du référencement Google

Vous débutez le référencement et êtes peut-être perdu face à la multitude d’outils présents sur le web pour vous aidez à ranker. Nous avons sélectionné pour vous certains outils (gratuits ou payants), utilisés par la plupart des agences et consultants, afin de vous guider dans vos choix et connaître leur utilité.

| Logo | Nom | Type d'outil | Descriptif |

|---|---|---|---|

|

Semrush | Analyse de marché et de site, Recherche de mots-clés | Semrush est un logiciel de type (SaaS). Celui-ci propose des forfaits pour étudier la visibilité naturelle d’un site web. Très connu dans l’univers du digital, il est très utilisé pour la recherche de mots-clés, l’analyse de la concurrence digitale ou encore la détection de “topics” dans une optique de création de contenu. Semrush est très complet et l’une des solutions les plus utilisées par les consultants. |

|

|

SEObserver | Analyse de marché et de site, Recherche de mots-clés | SEObserver est un logiciel français d'analyse de popularité (netlinking) ou de SERP. Créé par l’expert Kévin Richard, il est capable d’examiner la popularité à partir d’une requête ou d’une URL. De plus, il permet aussi de faire des comparaisons de performances entre noms de domaine ou d’avoir un visuel sur l’intensité concurrentielle d’un mot. |

|

Sistrix | Analyse de marché et de site, Recherche de mots-clés |

Sistrix est un outil d’aide au référencement naturel créé en 2008. Vous pouvez réaliser plusieurs choses :

|

|

Botify | Crawler, Analyse de Logs | Botify est un crawler et analyseur de logs lancé en 2014 par Adrien Ménard. Ce logiciel est spécialisé dans les logs (Botify Log Analyser) cependant, il existe d’autres solutions plus spécialisées comme Botify Analytics, Botify Keyword, Botify Intelligence, etc. Il s’agit d’un des crawlers les plus puissants et complets du marché avec un prix variant entre 40 et 800 € par mois. |

|

Oncrawl | Crawler, Analyse de Logs | Oncrawl permet de crawler, mais surtout d’explorer des logs de site web. Il permet de mettre en lumière les problèmes techniques ainsi que la distribution du « jus SEO » à travers le maillage interne. Il a la capacité d’analyser plusieurs millions d’URLs, mais à un certain prix. Son interface et sa précision en fait un allier idéal pour vos audits techniques. |

|

Screaming-Frog | Crawler | Screaming Frog est un crawler qui sert à analyser l’aspect technique d’un site. Il dispose de plusieurs fonctionnalités comme le mode “Spider” (autrement dit exploration d’URLs), le mode “List” qui permet de faire une recherche sur des URLs spécifiques, ainsi que le mode “SERP” et “Comparer” qui sont beaucoup moins utilisés. Screaming Frog simule un bots selon différents paramètres personnalisables et récupère diverses informations comme le code, le title, le H1 etc. |

|

Keyword Planner | Recherche de mots-clés | Le Keyword Planner est proposé par Google Ads. Il permet de faire de la recherche de mots-clés pour des campagnes publicitaires. Il offre la possibilité soit d’obtenir des données sur une liste de mots, soit d'en trouver des nouveaux. Ces données sont spécifiques à Google Ads, on y retrouve le nombre de clics, d’impressions, le CPC ou encore le CTR. Ces datas peuvent être utiles pour confirmer le choix de certains mots-clés. |

|

Yooda Insight | Recherche de mots-clés |

Yooda insight est un logiciel français d’analyse sémantique créé en 2002. Il dispose de plusieurs fonctionnalités :

|

|

Ahref | Exploration de backlink | Ahref est une solution payante qui permet d'explorer les liens entrants, les keywords et les concurrents. La solution existe depuis 2011 et a été lancée par Dmitry Gerasimenko. Ahref dispose de 3 forfaits (Lite, Standard, Advanced et Agency avec des tarifs allant de 89€ à 899€. En fonction de votre forfait, Ahref permet d’obtenir des data plus ou moins détaillées d’un site, d'accéder à une grande base de données pour trouver vos expressions ou encore d’auditer un site. |

|

Majestic | Exploration de backlink |

Majestic est un outil payant permettant d’analyser les backlinks d’un site web. Cette solution a été créée en 2004 par Alex Chudnovsky. Elle coûte entre 50 et 400€ par mois en fonction des différents abonnements (Silver, Gold et Platinum). L’outil est utilisé principalement pour :

|

|

|

SEOQuantum | Analyse sémantique, aide à la rédaction | SEOQuantum est une solution axée essentiellement sur la sémantique. Créé en 2018 par la société Quantum, il propose plusieurs features comme l’examen complèt d'un site, la recherche d'expressions, le suivi de positions ou encore l’aide à la création de cocons sémantiques. La solution existe en version gratuite (limitée) et en version payante. |

|

YourTextGuru | Analyse sémantique, aide à la rédaction |

YourtextGuru est une aide à la rédaction et une solution d’analyse sémantique créé par les frères Peyronnet. Celui-ci se base sur l’intelligence artificielle pour donner des suggestions de mots à travailler dans un texte afin de mieux ranker sur une requête. Il intègre plusieurs fonctionnalités comme :

|

|

1.fr | Aide à la rédaction | 1.fr facilite l’optimisation sémantique de textes en fonction de l’expression visée. Il vous permet de connaître le niveau d’optimisation SEO d’un document mais aussi le champ sémantique autour du mot-clé. L’intégration d’API et de plugin vous permet de l’utiliser sur n’importe quel document. Sa tarification démarre à partir de 60 € par mois et par internaute. |

|

MyPoseo | Suivi de positions |

Myposeo est un outil de suivi de positionnement créé en 2010. En plus du suivi de mots-clés, il existe d’autres fonctionnalités comme :

|

|

Ranxplorer | Suivi de positions | Ranxplorer permet d’analyser ou de trouver des mots-clés. Il dispose d’une synthèse globale avec un aperçu instantané du profil SEO. C’est un bon outil pour suivre les évolutions de positions. Il inclut aussi la recherche universelle ainsi. |

|

Dareboost | Webperf | Dareboost est une solution française de data de performance créée en 2014 à Rennes. Le logiciel dispose de nombreuses fonctionnalités de reporting, d’intégration d’API, de configuration, de tracking, etc. Celui-ci est limité à une exploration par jour en version gratuite et de façon illimitée avec l’abonnement standard à 19 €. |

|

Fasterize | Webperf |

Fasterize est une solution française d’optimisation de la vitesse de chargement. Il a été fondé par Vincent Mazières et Mehdi Aminian, deux experts en informatique. Fasterize permet d’optimiser plusieurs éléments impactants le temps de chargement comme :

|

|

Page Speed Insight | Webperf |

Google Page Speed Insight est une application en ligne gratuite de mesure de la vitesse de chargement de vos pages. Il se base sur la technologie Lighthouse et calcule la performance selon 5 facteurs :

|

|

WebPageTest | Webperf |

Webpagetest est une solution onligne qui permet de tester la performance d'un site en simulant des visites de navigateur. Il a été créé en 2008 par Patrick Meenan. Webpagetest est accessible gratuitement, mais il existe une version entreprise payante avec des fonctionnalités plus poussées. Il permet :

|

10. Les principaux évènements et conférences SEO en France

Etre curieux sur le référencement est une très bonne qualité pour devenir Consultant SEO. Nous avons la chance en France d’avoir plusieurs associations qui organisent un peu partout dans l’hexagone des conférences ou des évènements autour du Search. Des experts viennent de tout le pays pour partager des tips, analyses ou des tests réalisés. Si vous souhaitez assister à ces évènements pour monter en compétences et connaître les méthodes des autres référenceurs, découvrez notre liste des différents rassemblement.

| Logo | Evènement | Descriptif |

|---|---|---|

|

Black & White SEO | Le Black and White SEO est un événement lyonnais exclusivement consacré au référencement qui a lieu chaque année en mai. L’événement se veut 100% actionnable avec des astuces et tips réalisables pour améliorer les performances de votre business. On y retrouve des conférences mais aussi des échanges sur des cas concrets. |

|

Salon du e-Marketing |

Il s'agit d'une conférence sur le marketing digital et l’e-commerce depuis 2006. Dans cet événement on retrouve :

|

|

Search Y | C'est un événement payant spécialisé dans le search marketing en région parisienne. Cet événement a été créé par Philippe Yonnet, fondateur de l’agence Neper. Des professionnels du SEO, SEA, mais aussi des développeurs se donnent rendez-vous pour aborder divers sujets comme le la gestion du multilingue, la web performance ou encore l’intelligence artificielle. |

|

SEO Camp’us | Le SEOcamp’us est un événement français annuel réunissant des acteurs du Search. Présent dans plusieurs villes de France, cet événement existe depuis 2008 et rassemble les passionnés de tous niveaux. Cet événement est rythmé par des présentations de cas client, d’études, d’échanges sur des thématiques diverses et d’ateliers (profitez-en pour vous essayer à la QASEO). |

|

SEO Garden Party |

C'est un événement annuel français organisé par Olivier Andrieu, expert SEO et fondateur du site Abondance (repris par l’agence nantaise Khosi). Cet événement propose des conférences, ateliers et échanges sur les sujets récents du web avec différents intervenants. Voici quelques exemples de sujets abordés :

|

|

SEO Square | Une conférence virtuelle qui a lieu généralement en octobre. Totalement gratuite et en ligne, elle a déjà rassemblé plus de 4 550 participants. Cet événement cible principalement deux axes, le SEO et le content strategy. On y retrouve de nombreux experts comment Olivier Andrieu ou encore Nicolas Mercatili. |

|

SMX Paris | Le SMX ou Search Marketing Expo est une conférence se déroulant généralement en région parisienne. Le SMX a été créé en 2010 et se déroule sur 2 jours avec des intervenants français et internationaux. Sa portée mondiale et son ancienneté ont permis à des milliers d’entreprises et de professionnels d’échanger sur des sujets SEO, SEA et Social média. |

|

We Love SEO | C'est également un événement annuel français. Des professionnels, blogueurs, entrepreneurs échangent autour des bonnes pratiques SEO et sujets d’actualité. Le partage d’expérience et le réseautage font partie de cet événement. |

11. Quels sont les sites essentiels pour faire sa veille SEO ?

Abondance (et Réacteur)

Véritable bible de l’actualité du référencement naturel pour les francophones, le site Abondance a été créé en 1998 par Olivier Andrieu, consultant SEO indépendant depuis 1996.

Aujourd’hui, ce sont les Nantais de l’agence KHOSI qui ont repris le flambeau.

Vous trouverez sur Abondance tout le nécessaire pour être à la page concernant les dernières actus du monde du Search, des mises à jour algorithmiques à l’annonce de nouveaux outils.

Abondance étant principalement axé sur l’actualité du SEO, vous trouverez des articles plus détaillés portant sur des thématiques comme la gestion du budget crawl ou l’évaluation de la valeur d’un nom de domaine sur la lettre professionnelle mensuelle Réacteur.

WebRankInfo

En 2002, Olivier Duffez, consultant et éditeur de la plateforme My Ranking Metrics, lance WebRankInfo.

Aujourd’hui devenu la plus grande communauté francophone du référencement naturel, WebRankInfo propose notamment des dossiers thématiques illustrés et exhaustifs.

S’adressant à la fois aux débutants et confirmés, il est facile d’y trouver les réponses aux questions que vous vous posez, et bien plus encore !

Search Engine Land

Avec parfois plusieurs articles publiés par jour, SEL est une référence internationale pour les anglophones dans le domaine du SEO, mais également pour le PPC.

Proposant à la fois des articles sur l’actualité brûlante du SEO, des webinaires et des articles pratiques (par exemple, “4 main types of local links and how to earn them”), le journal décerne également chaque année les Search Engine Land Awards pour récompenser les meilleures initiatives SEO.

Search Engine Journal

La force de ce site Search Engine Journal ? Fondé en 2003, il s’inscrit dans une logique communautaire basée autour d’experts, qu’ils soient consultants indépendants ou employés.

Que vous souhaitiez éliminer des ressources bloquant le rendu, découvrir des astuces pour améliorer votre e-commerce ou encore comprendre en profondeur l’Helpful Content Update, SEJ saura répondre à vos besoins.

Vous trouverez également sur le site des guides pour les CWV, le netlinking ou les facteurs de ranking, et plus globalement tout le nécessaire pour parfaire vos connaissances du référencement organique.

Search Engine Roundtable

Se définissant comme “le pouls de la communauté du référencement”, SER est une ressource précieuse à la fois pour le référencement naturel Google, mais également sur Bing et Yahoo.

Son fondateur Barry Schwartz, propose par ailleurs une large base de données d’articles sur le cloaking, le spam, le copywriting ou encore le PPC. Le site vous aidera à développer votre savoir-faire en SEO, mais aussi en marketing de manière générale.

Plébiscité par les anglophones, cette source a su s’imposer comme une valeur sûre aux yeux des référenceurs.

Le blog de Moz

À l’époque où Moz était une start-up qui ne vendait pas encore de logiciels, son cofondateur, Rand Fishkin, décide de publier chaque vendredi des vidéos éducatives à destination des marketeurs : les fameux Whiteboard Fridays sont nés.

Depuis, Moz est devenue une entreprise incontournable dans l’univers du référencement naturel, le tout en continuant à développer des publications de haute qualité.

Vous pourrez notamment trouver des conseils liés au local, au link building ou à l’e-commerce, et toujours avec des astuces d’experts dans les vidéo Whiteboard Fridays.

Définition de l’EAT

Derrière l’acronyme EAT se cache 3 grands principes pour évaluer la qualité d’un site, à savoir : “Expertise, Authoritativeness, Trustworthiness” (Expertise, Autorité, Fiabilité).

Bien qu’il y ait toujours eu des critères de pertinence pour les Quality Raters, ces 3 facteurs d’évaluation ont été formalisés et mis en avant lors de la mise à jour de l’algorithme en 2018.

Le triptyque EAT n’est toutefois pas réductible à une machine: en effet, après examen de votre domaine par les robots, les Quality Raters (personnes missionnées par Google et en charge d’évaluer la qualité d’un site) effectuent une vérification afin de garantir de meilleurs résultats dans les SERPs.

Dans une démarche de référencement naturel efficace, la prise en compte des principes interdépendants EAT est indispensable lors de l’élaboration d’une stratégie web.

Une réflexion autour de ces 3 principes s’avère particulièrement importante pour les contenus des secteurs d’activités sensibles, appelés “YMYL” (“Your Money, Your Life” – santé, immobilier, juridique, finances…), mais représente un axe majeur de toute stratégie.

Expertise

Dans l’EAT, L’expertise (E) reflète votre niveau de connaissance dans la thématique traitée sur votre site aux yeux du géant Américain.

En effet, dans l’optique de proposer aux utilisateurs la meilleure UX possible, les webmasters doivent être en mesure de présenter des informations fiables.

Ainsi, si votre page présente un niveau d’expertise suffisant et une réelle valeur ajoutée, vous êtes perçu comme légitime, et vous serez positivement impactés.

Attention cependant : l’évaluation de l’expertise par Google n’est pas binaire.

Elle se présente plutôt sous forme de degrés d’expertise.

Vous pouvez trouver de précieux renseignements sur l’expertise dans les Quality Raters Guidelines.

Par exemple, pour prouver votre expertise, vous pouvez rédiger un texte détaillé, précis, à forte valeur ajoutée.

Qu’il s’agisse d’avis sur un restaurant ou d’une liste de conseils pour optimiser le sommeil, étoffer, détailler et sourcer vos informations vous permettra d’obtenir un jugement d’expertise favorable de la part de Google.

Cependant, ce signal impacte principalement les contenus dont les implications sont importantes pour le lecteur : ainsi, si vous tenez un site dont la thématique est la médecine, l’expertise sera un facteur prépondérant.

De ce fait, bien qu’une observation du quotidien puisse être suffisante pour être perçu comme un expert sur une thématique, certaines intentions de recherche dans les secteurs YMYL évoqués précédemment, comme “comment guérir de la grippe”, nécessitent une expertise élevée.

Authoritativeness

Le 2eme signal d’évaluation défini par Google pour améliorer l’UX est l’autorité (A) du créateur, du site et de ce qu’il contient.

Corrélée à l’expertise, votre autorité doit se développer au fur et à mesure que vous produisez des contenus de qualité. Ces derniers sont alors partagés, génèrent des backlinks vers votre site et augmentent la perception de votre autorité dans votre thématique.

Les signaux susceptibles d’améliorer votre autorité sont nombreux et sont déterminants.

Par exemple, vous pouvez :

- Développer votre présence de marque sur les réseaux sociaux ;

- Participer à des podcasts ;

- Rédiger des guest posts ;

- Etre relayé par un site d’autorité dans votre secteur d’activité ;

- Développer une application pour votre site ;

- Participer à des discussions sur des forums ;

- Développer vos pages “à propos”, “mentions légales” et “politique de confidentialité” ;

- Citer des sources crédibles dans vos contenus ;

- etc.

Cependant, pour le moment, le facteur principal pour augmenter votre autorité est l’obtention de backlinks provenant de sites disposant eux-mêmes d’une forte autorité dans votre thématique.

Pour cela, vous aurez besoin d’une stratégie de netlinking cohérente ainsi que des renseignements à fortes valeurs ajoutées que les internautes jugent qualitatives, et donc dignes d’être partagées et citées.

Vous l’aurez compris : si vous êtes reconnu comme un expert par les internautes, alors votre réputation se développera mécaniquement, et Google vous accordera une certaine confiance.

Trustworthiness

Le dernière notion au sein de l’EAT est la trustworthiness (T), ou fiabilité.

Cette notion de fiabilité regroupe l’ensemble des éléments qui prouvent que le site est crédible, dignes de confiance, et donc bénéfiques pour l’utilisateur.

Les facteurs englobés par la fiabilité sont nombreux, et intrinsèquement liés aux signaux nécessaires au développement de l’expertise et de l’autorité.

Parmi les bonnes pratiques nécessaires, on peut citer :

- Le développement constant de votre notoriété de marque ;

- La mise en place de signaux de réassurance : présence d’un encart de présentation de l’auteur d’un article, UX bien pensée, indication d’un numéro de téléphone et d’une adresse, présence d’un formulaire de contact, utilisation d’un certificat SSL, etc. ;

- La publication régulière et la mise à jour datée des contenus ;

- Et tant d’autres.

Il est difficile de dissocier les éléments EAT valorisés par les Quality Raters : en réalité, l’expertise, l’autorité et la fiabilité sont interdépendantes, et doivent former un ensemble cohérent.

Expérience

Le 15 décembre 2022, l’arrivée d’un quatrième critère autour de l’expérience au sein de l’EAT fait son apparition (qui devient alors l’EEAT).

Ici, la question que se posent les Quality Raters est la suivante : “est-ce que le contenu prouve un certain degré d’expérience sur le sujet traité ?”.

La logique de ce 4ème élément est qu’un utilisateur appréciera d’autant plus un contenu produit par une personne ayant une compétence avérée, et si possible directe, de la thématique abordée.

Si l’on en croit l’annonce de Google, l’expérience concerne principalement les thématiques qui ne rentrent pas dans la catégorie “YMYL”. Si vous donnez des conseils dans le domaine de la santé vous serez sûrement considéré sous le prisme de l’expertise. Les comparatifs ou tests semblent plutôt relever du critère de l’expérience.

Par exemple, un commentaire exhaustif suite à une visite de musée ou un comparatif de produits suffisamment détaillé auront sans doute d’excellentes chances d’être perçus comme apportant de la valeur ajoutée au lecteur.

Malgré tout, au moment de cette annonce, la démonstration de ce signal est encore nébuleux.

On peut cependant imaginer que les bonnes pratiques rejoindront celles des 3 principes précédents, avec une importance particulière accordée à un contenu unique, précis et original.

Définition du SEA

Le référencement payant est un canal d’acquisition qui offre une visibilité immédiate sur les résultats. Le SEA, qui signifie Search Engine Advertising, se base sur le principe d’enchères. Les marques paient pour afficher des annonces via des liens sponsorisés.

La monétisation se fait grâce à un système de CPC ou Coût Par Clic (créé par Bill Gross en 1998, fondateur de goto.com). Ce système se déploie également au CPM (Coût Par Mille impressions), CPA (Coût Par Achat) ou CPL (Coût Par Lead).

Quelques chiffres sur le SEA et Google Ads

Le géant de Mountain View dispose de sa propre solution avec Google Ads (anciennement Adwords). Celle de son concurrent principal Bing s’appelle Microsoft Ads (anciennement Bing Ads).

Pour arbitrer quelles annonces devront apparaître, la plateforme va utiliser plusieurs critères avant de les publier :

-

L’enchère : un prix au clic est fixé pour chaque expression ciblée en fonction de la concurrence

-

Le Quality Score : c’est un score de qualité de la landing page afin que les visiteurs soient satisfait du résultat. Il dépend de 3 facteurs (la landing page expérience, le CTR probable, la pertinence de la pub par rapport à la requête). Il existe plusieurs astuces pour améliorer son Quality Score.

-

Ces 2 éléments vont permettre de calculer l’AdRank (C’est le produit entre l’enchère et le Quality Score)

Cette formule va permettre de calculer le CPC pour l’annonceur. Il saura ainsi ce qu’il dépensera pour chacun des clics effectués sur les annonces.

Quelles sont les principales différences entre le SEA et le SEO ?

On a souvent tendance à dire que le référencement payant est… payant et le référencement organique, gratuit. C’est faux ! Ou alors bon courage pour réaliser votre stratégie SEO sans accroc et dans les plus brefs délais.

En général, le SEA coûte de l’argent car on investit une certaine somme pour être visible.

Pour le SEO, même si vous pouvez réaliser la plupart des tâches vous-même, cela demande énormément de temps et d’expertise.

Obtenir des backlink est fastidieux, rédiger des contenus aussi, des plateformes existent pour gagner en efficacité mais vous devrez payer pour bénéficier de ces services. Certaines entreprises n’ont pas les connaissances pour développer une vraie stratégie et passent donc par une agence. Tout cela a un coût.

La principale différence entre ces 2 canaux d’acquisition est le délai d’obtention des résultats et des performances. Vous obtiendrez les premiers effets presque immédiatement avec le payant alors qu’il faudra attendre plusieurs mois pour enregistrer les premières positions sur l’organique.

Avec le SEO vous obtiendrez des résultats pérennes et renforcerez votre notoriété de marque même si cela demande des efforts dans le temps. En revanche avec l’Ads, les performances s’arrêtent au moment où vous stoppez les campagnes. Mais vous pourrez viser plus facilement votre cible et la plupart des expressions concurrentielles sont atteignables.

Ces sources d’acquisition peuvent être très complémentaires et doivent être pensées en amont de votre stratégie digitale :

-

Lorsque vous débutez votre business, l’Ads pourra vous donner des résultats rapidement le temps de mettre en place votre stratégie de référencement naturel.

-

Si des requêtes sont trop concurrentielles en naturel, vous pourrez utiliser le SEA pour être visible

-

Enfin, si votre business est saisonnier, le PPC boostera vos performances en plus du naturel.

14. Pourquoi une agence SEO est indispensable pour faire son référencement Google ?

Une agence de référencement naturel comme Tactee est indispensable pour performer sur ce canal d’acquisition. C’est le fruit de longues années d’expertises. Les consultants gèrent de nombreux sites tous différents les uns des autres (sites vitrines, e-commerce, internationaux, d’actualité, géolocaux…). Les objectifs clients sont différents, leur organisation en interne varie.

Une agence connaît donc toutes ces problématiques et est capable de se montrer flexible pour ses partenaires.

C’est aussi une entreprise équipée d’outils (externe ou interne) difficile à se procurer si l’on travaille son référencement tout seul car très coûteux pour certains. Ils peuvent devenir très puissants lorsqu’un expert sait les utiliser.

Ses nombreux retours d’expériences lui permettent de réaliser des stratégies et des préconisations très avancées.

Confier votre stratégie de référencement à une agence vous fera gagner du temps sur des tâches plus urgentes lorsque l’on est chef d’entreprise ou employé chez un annonceur.

Si vous êtes arrivés au bout de ce contenu, bravo à vous. Vous connaissez maintenant l’essentiel de ce canal d’acquisition pour votre business.

Vous êtes maintenant intéressés pour poursuivre l’aventure avec nous ?

C'est par ici!